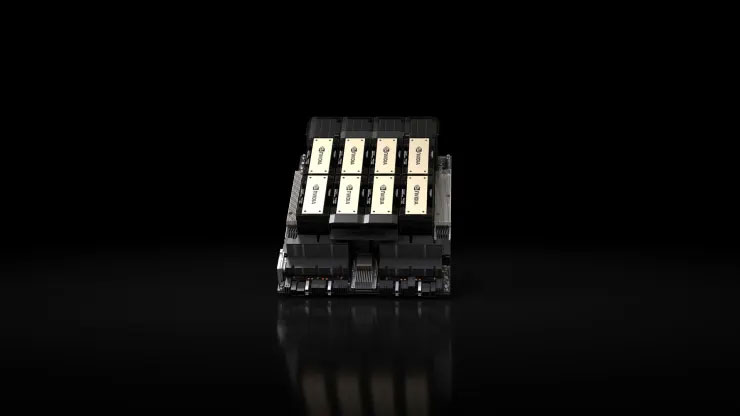

13 ноября 2023 года компания Nvidia представила H200 — передовой графический процессор (GPU), предназначенный для обучения и развертывания передовых моделей искусственного интеллекта, лежащих в основе нынешней революции генеративного искусственного интеллекта. Новый графический процессор представляет собой обновление своего предшественника H100. , который OpenAI использует для обучения своей самой сложной языковой модели, GPT-4. Ограниченное количество этих чипов вызвало жесткую конкуренцию среди крупных компаний, стартапов и государственных учреждений. Чипы Nvidia H200 GPU.webp H100 стоят от 25 000 до 40 000 долларов США, по данным По оценкам Рэймонда Джеймса, большое количество этих чипов необходимо объединить, чтобы облегчить обучение крупнейших моделей — процесс, называемый «обучением». Влияние графических процессоров Nvidia для искусственного интеллекта на рынок привело к значительному росту цен на акции компании. в 2023 году вырастет более чем на 230%. NVIDIA ожидает, что выручка в третьем квартале составит примерно 16 миллиардов долларов, что на 170% больше, чем в предыдущем году.

H200 достигает значительных успехов за счет интеграции 141 ГБ современной памяти «HBM3», что повышает производительность чипа во время процесса «вывода». Вывод включает в себя развертывание обученной модели для генерации текста, изображений или прогнозов. Nvidia утверждает, что H200 может генерировать выходные данные. почти в два раза быстрее, чем его предшественник H100, и тестирование с использованием Llama 2 LLM от Meta доказывает это. H200 будет выпущен во втором квартале 2024 года и будет конкурировать с графическим процессором AMD MI300X, который имеет аналогичные характеристики, а также имеет расширенные возможности памяти для размещения большие модели вывода. Существенным преимуществом H200 является его совместимость с H100, что позволяет компаниям, занимающимся искусственным интеллектом, которые в настоящее время используют старые модели, легко интегрировать новую версию без необходимости внесения изменений в серверные системы или программное обеспечение. H200 можно интегрировать в четырех- или конфигурации серверов с восемью графическими процессорами через комплексные системы Nvidia HGX, а также есть чип под названием GH200, который сочетает в себе графический процессор H200 с процессором на базе Arm. Однако доминирование H200 как самого быстрого AI-чипа Nvidia может быть временным. Хотя Nvidia предлагает множество Что касается конфигураций чипов, то крупные улучшения обычно происходят каждые два года, когда производители внедряют новые архитектуры, открывая значительный прирост производительности, помимо простого увеличения памяти или других незначительных оптимизаций. И H100, и H200 основаны на архитектуре Nvidia Hopper. В октябре Nvidia сообщила инвесторам, что будет переход к модели выпуска в течение одного года вместо двухлетнего цикла архитектуры из-за высокого спроса на ее графические процессоры. Компания поделилась слайдом, намекающим на анонс в 2024 году и выпуск процессора на базе BlackW. Nvidia представила H200 13 ноября, 2023, передовой графический процессор (GPU), предназначенный для обучения и развертывания передовых моделей искусственного интеллекта, движущих нынешнюю революцию в области генеративного искусственного интеллекта. Новый графический процессор представляет собой обновление своего предшественника H100, который OpenAI использует для обучения своих самых сложных языковая модель GPT-4. Ограниченное количество этих чипов вызвало жесткую конкуренцию среди крупных компаний, стартапов и государственных учреждений. Чипы Nvidia H200 GPU.webp H100, по оценкам Рэймонда Джеймса, стоят от 25 000 до 40 000 долларов США, и большое количество таких чипов Чипы должны быть объединены, чтобы облегчить обучение крупнейших моделей. Этот процесс называется «обучением». Влияние графических процессоров Nvidia для искусственного интеллекта на рынок привело к значительному росту цен на акции компании, которые в 2023 году выросли более чем на 230%. .Nvidia ожидает, что выручка в третьем квартале составит около $16 миллиардов, что на 170% больше, чем в предыдущем году. H200 достигает значительных успехов за счет интеграции 141 ГБ ультрасовременной памяти HBM3, что повышает производительность чипа во время «вывода». процесс. Вывод включает в себя развертывание обученной модели для генерации текста, изображений