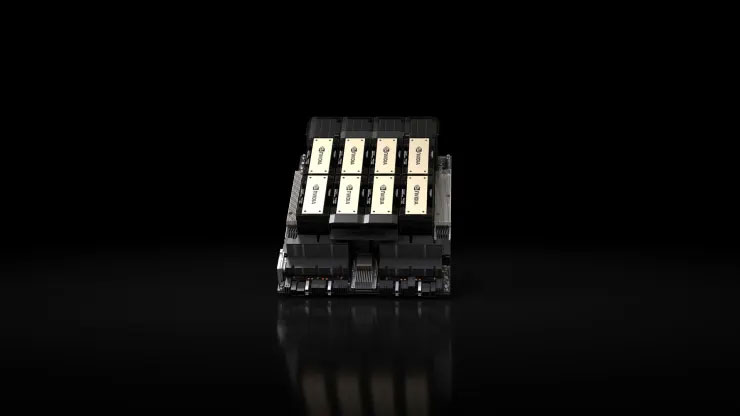

Nvidia 于 2023 年 11 月 13 日推出了 H200,这是一款尖端图形处理单元 (GPU),专为训练和部署推动当前生成式 AI 革命的先进人工智能模型而定制。新 GPU 是其前身 H100 的升级版, OpenAI 用它来训练其最复杂的语言模型 GPT-4。这些芯片的供应有限,引发了大公司、初创公司和政府机构之间的激烈竞争。根据雷蒙德的说法,Nvidia H200 GPU.webp H100 芯片的成本在 25,000 美元到 40,000 美元之间James估计,必须将大量的这些芯片组合起来,以促进最大模型的训练,这个过程称为“训练”。 Nvidia的AI GPU对市场的影响导致该公司股价大幅飙升,2023 年迄今增长超过 230%。英伟达预计第三季度营收约为 160 亿美元,较上年增长 170%。

H200 通过集成 141GB 尖端的“HBM3”内存实现了重大进步,增强了芯片在“推理”过程中的性能。推理涉及部署经过训练的模型来生成文本、图像或预测。Nvidia 声称 H200 可以生成输出速度几乎是其 H100 前身的两倍,使用 Meta 的 Llama 2 LLM 进行的测试证明了这一点。H200 将于 2024 年第二季度发布,并将与 AMD 的 MI300X GPU 竞争,后者具有类似的属性,并且还具有增强的内存能力以适应H200的一个显着优势是与H100的兼容性,允许目前使用旧型号的AI公司无缝集成新版本,而无需更改服务器系统或软件。H200可以通过Nvidia的HGX完整系统集成到四或八GPU服务器配置中,还有一款名为GH200的芯片,它将H200 GPU与基于Arm的处理器相结合。然而,H200作为Nvidia最快的AI芯片的主导地位虽然 Nvidia 提供各种芯片配置,但当制造商采用新架构时,通常每两年就会出现一次重大进步,从而释放显着的性能增益,而不仅仅是内存增加或其他较小的优化。H100 和 H200 都基于 Nvidia 的 Hopper 架构。英伟达告诉投资者,由于对其 GPU 的需求量很大,它将过渡到一年发布模式,而不是两年架构节奏。该公司分享了一张幻灯片,暗示将于 2024 年宣布并推出基于 BlackW 的 Nvidia 于 2023 年 11 月 13 日推出了 H200,这是一款尖端图形处理单元 (GPU),专为训练和部署驱动当前的生成式人工智能革命。新的GPU是其前身H100的升级版,OpenAI用它来训练其最复杂的语言模型GPT-4。这些芯片的有限供应引发了大公司、初创公司和政府之间的激烈竞争根据 Raymond James 的估计,Nvidia H200 GPU.webp H100 芯片的成本在 25,000 美元到 40,000 美元之间,并且必须将大量这些芯片组合起来以促进最大模型的训练,这一过程称为“训练”。 'AI GPU的上市导致该公司股价大幅飙升,2023年迄今已上涨超过230%。英伟达预计第三季度营收约为160亿美元,较上年增长170% H200通过集成141GB尖端“HBM3”内存实现了重大进步,增强了芯片在“推理”过程中的性能。推理涉及部署经过训练的模型来生成文本、图像。“推理”过程中的表现。推理涉及部署经过训练的模型来生成文本、图像“推理”过程中的表现。推理涉及部署经过训练的模型来生成文本、图像