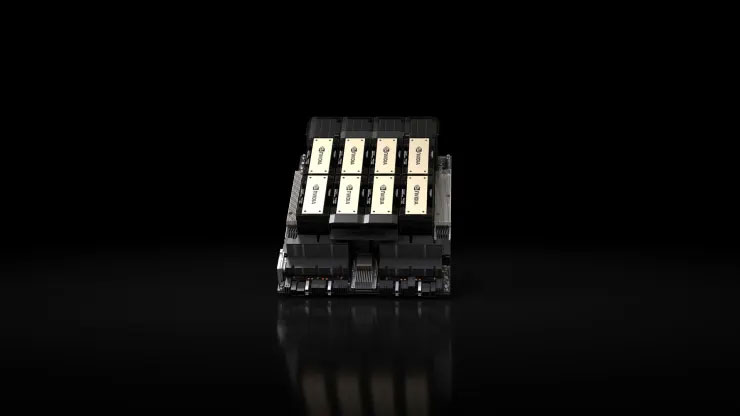

Nvidia brachte am 13. November 2023 den H200 auf den Markt, einen hochmodernen Grafikprozessor (GPU), der auf das Training und den Einsatz der fortschrittlichen Modelle der künstlichen Intelligenz zugeschnitten ist, die die aktuelle generative KI-Revolution vorantreiben. Der neue GPU ist ein Upgrade gegenüber seinem Vorgänger, dem H100. mit dem OpenAI sein komplexestes Sprachmodell, GPT-4, trainiert. Das begrenzte Angebot dieser Chips hat zu einem harten Wettbewerb zwischen großen Unternehmen, Start-ups und Regierungsbehörden geführt. Nvidia H200 GPU.webp H100-Chips kosten laut Raymond zwischen 25.000 und 40.000 US-Dollar James schätzt, dass eine große Anzahl dieser Chips kombiniert werden muss, um das Training der größten Modelle zu erleichtern, ein Prozess, der „Training“ genannt wird. Die Auswirkungen der KI-GPUs von Nvidia auf den Markt haben zu einem deutlichen Anstieg des Aktienkurses des Unternehmens geführt Bisher mehr als 230 % im Jahr 2023. Nvidia erwartet im dritten Quartal einen Umsatz von etwa 16 Milliarden US-Dollar, was einer Steigerung von 170 % im Vergleich zum Vorjahr entspricht.

Der H200 erzielt erhebliche Fortschritte durch die Integration von 141 GB hochmodernem „HBM3“-Speicher, wodurch die Leistung des Chips während des „Inferenz“-Prozesses verbessert wird. Bei der Inferenz wird ein trainiertes Modell eingesetzt, um Text, Bilder oder Vorhersagen zu generieren. Nvidia behauptet, dass der H200 Ausgaben generieren kann Fast doppelt so schnell wie sein H100-Vorgänger, und Tests mit Metas Llama 2 LLM beweisen dies. Der H200 wird im zweiten Quartal 2024 auf den Markt kommen und mit der MI300X-GPU von AMD konkurrieren, die über ähnliche Eigenschaften verfügt und außerdem über verbesserte Speicherkapazitäten verfügt große Inferenzmodelle. Ein wesentlicher Vorteil des H200 ist seine Kompatibilität mit dem H100, die es KI-Unternehmen, die derzeit ältere Modelle verwenden, ermöglicht, die neue Version nahtlos zu integrieren, ohne dass Änderungen an Serversystemen oder Software erforderlich sind. Der H200 kann in vier oder mehrere Modelle integriert werden Acht-GPU-Serverkonfigurationen über Nvidias HGX-Komplettsysteme, und es gibt auch einen Chip namens GH200, der die H200-GPU mit einem Arm-basierten Prozessor kombiniert. Allerdings könnte die Dominanz des H200 als Nvidias schnellster KI-Chip nur vorübergehend sein. Während Nvidia eine Vielfalt bietet Bei den Chipkonfigurationen kommt es in der Regel alle zwei Jahre zu großen Fortschritten, wenn Hersteller neue Architekturen einführen und erhebliche Leistungssteigerungen ermöglichen, die über bloße Speichererweiterungen oder andere kleinere Optimierungen hinausgehen. Sowohl der H100 als auch der H200 basieren auf der Hopper-Architektur von Nvidia. Im Oktober teilte Nvidia den Investoren mit, dass dies der Fall sein würde Übergang zu einem einjährigen Release-Modell anstelle eines zweijährigen Architekturrhythmus aufgrund der hohen Nachfrage nach seinen GPUs. Das Unternehmen teilte eine Folie mit, die auf eine Ankündigung und Einführung eines BlackW-basierten 2024 hinweist. Nvidia brachte den H200 am 13. November auf den Markt. 2023, eine hochmoderne Grafikverarbeitungseinheit (GPU), die auf das Training und den Einsatz der fortschrittlichen Modelle der künstlichen Intelligenz zugeschnitten ist, die die aktuelle generative KI-Revolution vorantreiben. Die neue GPU ist ein Upgrade gegenüber ihrem Vorgänger, dem H100, mit dem OpenAI seine komplexesten Teile trainiert Sprachmodell, GPT-4. Das begrenzte Angebot dieser Chips hat zu einem harten Wettbewerb zwischen großen Unternehmen, Start-ups und Regierungsbehörden geführt. Nvidia H200 GPU.webp H100-Chips kosten nach Schätzungen von Raymond James zwischen 25.000 und 40.000 US-Dollar, und davon gibt es große Mengen Chips müssen kombiniert werden, um das Training der größten Modelle zu erleichtern, ein Prozess, der als „Training“ bezeichnet wird. Die Auswirkungen der KI-GPUs von Nvidia auf den Markt haben zu einem erheblichen Anstieg des Aktienkurses des Unternehmens geführt, der im Jahr 2023 bisher um mehr als 230 % gestiegen ist .Nvidia erwartet im dritten Quartal einen Umsatz von rund 16 Milliarden US-Dollar, was einer Steigerung von 170 % im Vergleich zum Vorjahr entspricht. Der H200 erzielt erhebliche Fortschritte durch die Integration von 141 GB hochmodernem „HBM3“-Speicher, wodurch die Leistung des Chips während der „Inferenz“ verbessert wird. Bei der Prozess.Inferenz wird ein trainiertes Modell eingesetzt, um Text und Bilder zu generieren